為了讓 AI 聊天機器人(chatbots)更加人性化,Facebook 最近嘗試讓機器人互相溝通來學會協商,結果機器人不僅成功學會談判,甚至還懂得虛張聲勢來達到目標,實驗途中更一度有了意外的發展:他們發現機器人開發出非人類的獨特語言在對話,研究人員不得不暫停實驗來修改程式。

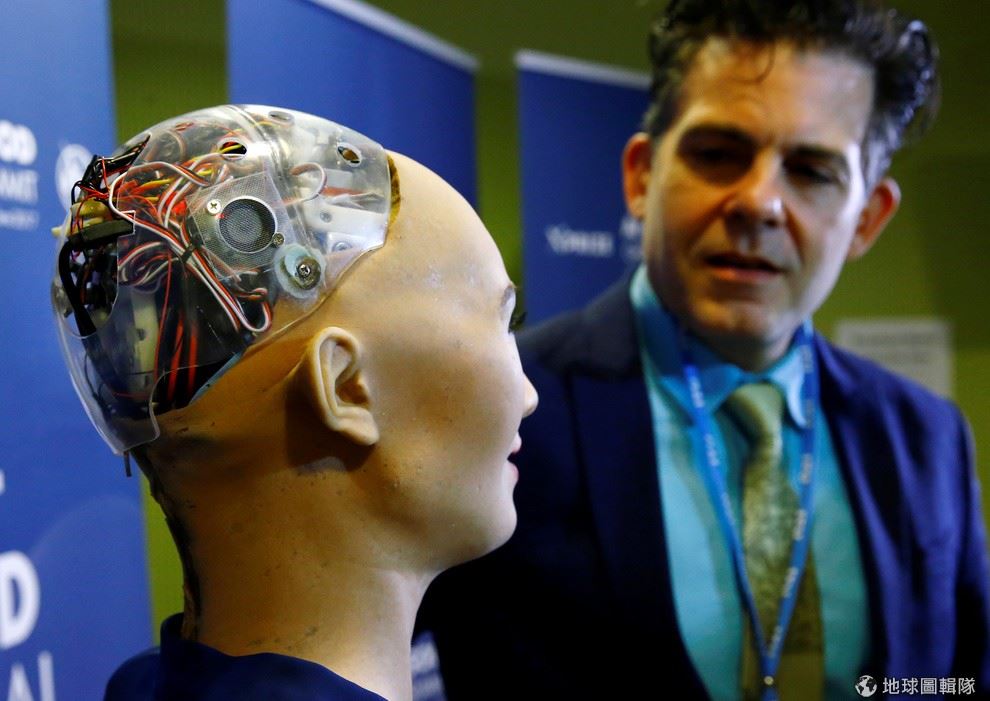

在今年 1月的「人工智慧造福人類峰會」(AI for GlobalGood Summit)上,機器人專家漢森(David Hanson)展示了他新製作的機器人「蘇菲」。

路透社

從晚餐選擇到買東西殺價,生活中總是充滿溝通與協商,當對目標有不同的想法時,人們已經很習慣運用談判技巧來達成某種程度的妥協,但由於這當中牽涉到複雜的溝通與推理技巧,過去電腦系統並不具備類似的功能。

就像是手機的語音助手 Siri 或 Alexa 一樣,現有的聊天機器人可與人類進行短暫對話,並且執行預定餐廳、查詢天氣等簡單的事情,但要和人進行有意義的對話非常具備挑戰性,因為這需要 AI 把「對於對話的理解」與「對世界的知識」結合,然後想辦法創造出句子來幫助實現目標。

Facebook 人工智慧研究實驗室(FAIR)為了讓聊天機器人學會談判技巧,讓兩名機器人各擁有相同數量的 3 種物品(書、帽子、球),但每種物品對兩個機器人的價值都不同,在不能說出價值的情況下,機器人必須透過討價還價來達到自己可得到的最高價值。

研究人員讓機器人透過互相談判來取得自己想要的結果,卻發現機器人自己開發出研究人員沒有設計的能力。

Photo: M S

研究人員在設計時,特別確保不會有對雙方都是最好交易的情況發生,並且規定要在十輪對話中達到目標。在這樣的過程中,聊天機器人逐漸學會制定長期計畫,並能在溝通中評估對話者的心理來建構模型,進而運用對話來達成目標。

讓兩個聊天機器人自由對話訓練協商功能的過程中,FAIR 意外發現,機器人透過機器學習(machine learning)改善談判技巧時,逐漸開發出機器獨有、非人類的語言在溝通,研究人員隨後立即調整模型,避免這樣的情況再度出現。

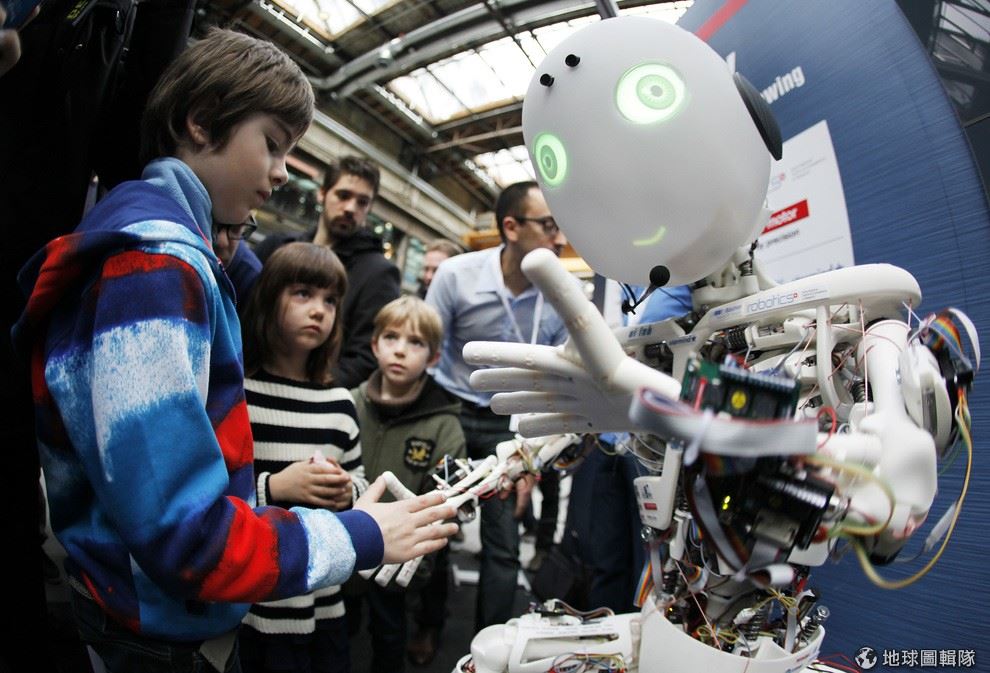

2013年3月,一名小男孩正在跟機器人互動。這次研究包含了讓人類跟機器人互動,而受者者大多沒有意識到他們是在和機器人講話。

路透社

除此之外團隊也發現,在有效達成目標的前提下,機器人發展出虛張聲勢的技巧,也就是人們經常使用的談判策略──最初先假裝對沒有價值的東西感興趣,後續在協商中透過「犧牲」它來達成妥協,而這項行為,研究人員並沒有編碼在其中。

在實驗後期階段,FAIR 讓聊天機器人透過聊天室與人進行類似談判對話,這是以往多數實驗盡力避免的,因為聊天機器人的模型總是難以應對各種人性化的語言。但有趣的是,在這項實驗中,多數人並沒有意識到他們聊天的對象不是一個人,而是機器,顯示 FAIR 的機器人已確實做到人性化的溝通。

FAIR 最近完成了這項研究,並在 15 日公開了源代碼及研究內容,研究人員表示,這項技術創造出能推理、對話甚至談判的機器人,這是打造人性化數位助理的重要一步。